En los últimos meses, las noticias sobre avances en inteligencia artificial no han dejado de crecer. Que si un ordenador ha hecho esto, un ordenador ha hecho lo otro. Aunque algunas son buenas noticias sobre avances en el campo, hay un buen porcentaje que tiene un tinte perturbador: en 2016, Microsoft liberó una cuenta en Twitter controlada por un chatbot, que, en menos de 24 horas, se volvió racista, homófobo y radical. Lo mismo ocurrió hace poco con un robot conversador que analizaba contenido en Internet para poder dar sus respuestas, que amenazó a su interlocutor con “meterlo en su zoo de humanos”. La noticia reciente más sonada, sin embargo, ha sido que Facebook apagó una IA por desarrollar un lenguaje no comprensible por los programadores.

Por otro lado, la IA cada vez es mejor realizando tareas humanas: por primera vez, una inteligencia artificial ha superado al ser humano al Go. Y el superordenador Watson dió un buen repaso en el programa norteamericano Jeopardy de preguntas y respuestas, mostrando que es capaz de entender y responder de manera totalmente natural en una conversación al presentador… y que puede obtener prácticamente cualquier dato en cuestión de segundos.

Juntemos ambas cosas y tendremos el resultado final: ¡una inteligencia artificial malvada, que actúa sin que nosotros lo sepamos, que es capaz de superarnos en prácticamente cualquier tarea! ¿Vamos a desaparecer todos los humanos en beneficio de una nueva raza de cyborgs?

Cómo funciona una IA

Primero, me gustaría aclarar algunos conceptos básicos, de forma sencilla, de cómo funciona una inteligencia artificial, dónde se está aplicando ahora mismo, y qué utilidad tiene para nosotros.

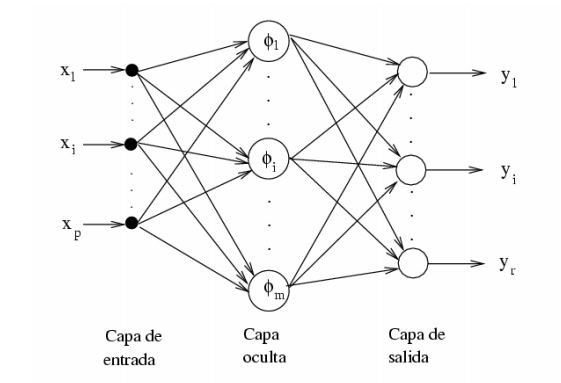

Una IA es un programa que imita la forma de funcionar de nuestro cerebro. El programa tiene una serie de neuronas, conectadas entre sí a través de enlaces o sinapsis artificiales. Las neuronas pueden estar activas o inactivas. Las primeras mandan señales a través de las sinapsis, que son recibidas por las neuronas vecinas; las que reciben suficiente nivel de señal se activan, y las que no, se apagan. Las neuronas se estructuran habitualmente formando capas, como muestra la imagen.

Ilustración 1: Una red neuronal formada por 3 capas, y 3 neuronas en cada capa. Las sinapsis se muestran con flechas.

La primera capa es la de entrada. Ante cierto estímulo externo, algunas neuronas de la entrada se activan, y envían el resultado de la operación a la segunda capa. Estas envían el resultado a la siguiente capa, y así sucesivamente, hasta llegar a la última, la capa de salida. Dependiendo de las neuronas activas en la salida, se realiza una acción u otra.

Ahora bien, la pregunta del millón es, ¿cómo conseguimos conectar las neuronas unas con otras para realizar una tarea complicada? El procedimiento habitual es generar varias redes diferentes, habitualmente de forma aleatoria, y después ponerlas a trabajar. Estas redes están generadas de cualquier manera, y por tanto desempeñarán su tarea de una forma pésima. Sin embargo, vamos a fijarnos en aquella red que lo hace mejor. La cogemos y le hacemos cientos de copias, con ligeras modificaciones aleatorias. Esta nueva generación de redes realizará la tarea, y cogeremos nuevamente a la que mejor la realice. Poco a poco, las redes irán mejorando su rendimiento, hasta llegar a un punto en el cual nuestra inteligencia artificial es capaz de realizar su tarea prácticamente a la perfección.

Por supuesto, actualmente hay mejoras a esta forma de proceder. Por ejemplo, la IA campeona de Go, AlphaGo no solo jugó partidas y fue cambiando su red en función de sus resultados, sino que sus creadores le permitieron estudiar partidas, es decir, ir modificando su red empleando los datos de partidas reales entre jugadores profesionales. La idea es que el ordenador aprenda por imitación cómo reaccionan los jugadores profesionales ante ciertos escenarios habituales, lo cual hace avanzar más rápidamente y de forma segura el proceso de aprendizaje. También, en el caso de AlphaGo, otra forma de avanzar es jugar partidas contra él mismo, de las que puede aprender.

Además, hay que tener en cuenta que la red neuronal se emplea a menudo porque su entrenamiento permite un alto rendimiento, pero hay ocasiones en las que no merece la pena. Por ejemplo, en las damas. No es un juego con muchas posibilidades, y el ordenador puede guardar todos los movimientos posibles y sus respuestas en memoria. Una vez el jugador hace su primer movimiento, el ordenador puede ir moviéndose por el árbol de partidas posibles para llegar siempre a la victoria. No hace falta entrenarlo, ni que aprenda nada, simplemente él conoce siempre la mejor respuesta a cualquier movimiento. Y será mejor que cualquier aterradora IA.

En el caso de juegos como el Go, este mecanismo no es posible: hay 10120 partidas posibles (¡frente a 1080 átomos en todo el universo!), de modo que no se pueden guardar en la memoria, ni simularlas todas. Por eso, el ordenador en este caso juega igual de “ciego” que una persona: tiene que entrenar para averiguar cuáles son los posibles movimientos, y usar algoritmos de búsqueda más avanzados para encontrar la mejor jugada posible.

Sin embargo, hay que hacer hincapié en que estas redes artificiales están lejísimos de la capacidad humana. Se estima que el cerebro tiene aproximadamente 86.000 millones de neuronas, y del orden de 150 billones de sinapsis (es decir, 150 millones de millones de sinapsis). Por poner el ejemplo de AlphaGo, tiene trece capas, las cuales cada una tiene cerca de 400 neuronas. El número de neuronas que alcanza esta red neuronal es ínfimo comparado con el de una persona, y, además, está preparado para tomar como input un tablero de Go y como output un movimiento: no parece un candidato muy probable a ser Terminator. Pero, ¿y qué pasa con el resto?

Ilustración 2: Lee Sedol, campeón mundial de Go, perdió contra la inteligencia AlphaGo desarrollada por Google. Sedol no se esperaba esta derrota. (AP Photo/Lee Jin-man)

Las inteligencias artificiales se usan en multitud de aplicaciones inocentes. Por ejemplo, la búsqueda por imágenes de Google, que busca imágenes similares a una que subimos al servidor, emplea esta tecnología. En general, la IA está ayudando mucho al desarrollo del reconocimiento de imágenes por ordenador: buscar patrones es muy fácil para las personas, puesto que nuestro cerebro lleva millones de años evolucionando con el objetivo de aprender a reconocer estos patrones, que es una tarea fundamental para la supervivencia. Sin embargo, hasta el momento ha sido muy complicada para los ordenadores.

Por este motivo, muchas pruebas médicas como los electrocardiogramas eran analizados por personas, que están entrenadas para buscar algunos patrones característicos de una anomalía en los latidos del corazón. Con el auge de la IA en el reconocimiento de patrones en datos e imágenes, actualmente hay una buena cantidad de iniciativas para hacer más rápido y fácil el diagnóstico de enfermedades: ¿es un lunar benigno o maligno? ¿hay anomalías en un electrocardiograma? El desarrollo de estas tecnologías permitirá hacer análisis fiables y rápidos de problemas de salud graves, descongestionando la salud pública y permitiendo un diagnóstico precoz en situaciones donde es muy importante: y todo esto se hace de una forma muy similar a AlphaGo. Cogemos una red neuronal, le pasamos miles de datos de electrocardiogramas de sanos, luego de electrocardiogramas de enfermos, y le permitimos aprender a distinguir unos de otros.

¿Es peligroso el desarrollo de la IA?

Por el momento, esto es una pregunta más filosófica que técnica, pero tenemos algunas respuestas parciales. Desde luego, una IA, tal y como la he descrito en el apartado anterior, está claro que no tiene nada de especial: es un programa más, igual que un procesador de textos, un navegador web o un editor de fotos. Es un programa que tiene una entrada, que procesa para dar una salida. El programa está únicamente entrenado para realizar una tarea, solo sabe hacer eso y no puede realizar nada que no sea eso. AlphaGo no se va a convertir por sí mismo en un programa capaz de autoreprogramarse, sencillamente, porque no tiene la opción de hacer eso, igual que nadie sospecha de que Microsoft Word o Photoshop vayan a reprogramarse y dominar el mundo.

Sin embargo, las IAs que dan conversación asustan a menudo, y cuando una nueva aparece, son noticia. Habitualmente estas IAs dicen cosas, cuando menos, sospechosas. No hay más que meterse en la cuenta de Tay, la IA liberada por Microsoft en Twitter, que se hizo racista en menos de un día. El motivo es que la forma de aprendizaje de esta IA es con la interacción de otros usuarios de Twitter. Los lectores que conozcáis Twitter, podéis entender rápidamente el por qué de este resultado. Los trolls interactuaron con ella de forma masiva. La IA no se volvió malvada por sí misma, ni desarrolló odio hacia ningún colectivo: al igual que AlphaGo solo puede jugar al Go, Tay solo puede hablar y responder. Que eso nos parezca humano no la dota de sentimientos, pensamientos o consciencia. Tay aprende a repetir cosas, no odia a los colectivos. El programa fue solamente un reflejo de los usuarios que interaccionaron con ella, y no una demostración de autodeterminación o consciencia propia. Si queréis buscar el mal en algún sitio en el caso de Tay, es tan sencillo como entrar en Twitter y navegar un poco entre las discusiones de los usuarios.

En general, este es un problema del que adolecen casi todas las IAs conversacionales es que los sitios donde pueden aprender en Internet están plagadas de usuarios radicales o trolls, y más cuando saben que su interlocutor es un programa. Cuando una IA conversacional ha sido entrenada para entender y responder a preguntas en un entorno controlado, parece mucho más inteligente y educada. Un ejemplo de este caso es Watson, desarrollada por IBM, que puede mantener una conversación en tiempo real, contestar de forma natural, y que no tiene ninguna clase de ideología o idea malvada… porque no ha aprendido a conversar con los trolls de Internet. Pero claro, como no ha tenido ningun “desliz” diciendo que mataría gente, no ha tenido tanta repercusión.

El problema es que tendemos a dotar de inteligencia a lo que se parece a nosotros. Si hablamos con una IA conversacional con acceso a una base de datos, parece muy humana e inteligente, porque su entrenamiento es capaz de reconocer las preguntas y dar como salida una respuesta coherente, muy parecida a la que haría una persona. Nosotros tendemos a asociar que hay una inteligencia real detrás de eso, que puede pensar por sí misma, pero esto no es verdad: solo puede escuchar y contestar. Es una especie de “pareidolia psicológica” que tenemos con los robots.

Por otro lado, el perturbador robot conversador que mencionaba al principio del artículo, es un robot construido en homenaje a Philip Dick, el renombrado autor de ciencia ficción, que era conocido por su particular sentido del humor. El robot imita este sentido del humor, muy probablemente guiado por su programador. Es decir, que es posible que muchas de las respuestas de este robot estuvieran precocinadas. Esto se puede sospechar porque androides anteriores de este mismo creador tienen una actitud muy similar en esta clase de preguntas, lo que da a penar que es más bien una broma del programador. Desde luego, estos comentarios sobre la destrucción de la humanidad por los robots sirven para que una empresa gane rápidamente atención mediática.

Volviendo a nuestro tema: las IAs dedicadas a una tarea no son peligrosas. Son un programa más, igual que muchos otros, que realizan su tarea y están a las órdenes del programar. Son exóticos en el sentido de que para hacer su tarea han tenido que ser entrenados en un proceso de aprendizaje, pero me gustaría recalcar que el proceso de aprendizaje de una IA es también diferente al de un humano. En una persona, asociamos experiencias con nuestras respuestas. Una IA “aprende” cuando hacemos cientos de réplicas de sí misma y cogemos las que funcionan mejor. Por tanto, más bien deberíamos decir que a una IA se le hace evolucionar, pero no que “aprende” en el sentido humano.

Ilustración 3: Portada original de «Yo, Robot», una de las novelas más populares de Isaac Asimov. Un clásico de la ciencia ficción que gira en torno a la singuralidad tecnológica y al concepto de consciencia en inteligencia artificial.

Sin embargo, hay una clase de IA potencialmente peligrosa: la que es consciente de su existencia y su naturaleza. En ciencias de la computación, a esta clase de inteligencia artificial se le da el atrayente nombre de singularidad. Esta es la única IA que podríamos considerar, digamos, inteligente en el sentido humano. Ahora bien, el problema es que realmente tampoco sabemos qué es exactamente la consciencia. Entender el concepto de la consciencia o su origen ahora mismo es muy, muy lejano en neurociencia. Y esto, además, nos lleva a la siguiente pregunta: ¿cómo detectamos la consciencia? Y si una IA conversacional extraordinariamente avanzada afirma que es consciente, ¿cómo lo comprobamos?

Aunque hay algunos test para comprobar el grado de consciencia de una especie (que se han usado para ver hasta qué punto el resto de especies animales son conscientes), muchos son difíciles de aplicar a una inteligencia artificial. Pero el problema podría ser peor, dado que podría ser que existieran formas distintas de consciencia, y que la IA fuera consciente de sí misma, pero en un modo muy distinto del que lo entendemos nosotros. Este es el mismo problema que se está planteando últimamente en la búsqueda de vida extraterrestre: siempre hemos buscado agua y vida basada en el carbono, pero esto es un sesgo: ¿y si hay vida que no necesita el agua, que se basa en otro elemento químico? ¿y si hubiera vida de una forma tan distinta que nos costara reconocerla como tal?

Por supuesto, algunas IAs son peligrosas, pero para eso no hace falta irnos a escenarios como Yo Robot o Terminator. Por ejemplo las armas autónomas que investigan los Estados Unidos, que consisten por ejemplo en un enjambre de aviones autónomos a las órdenes de un único “caza líder”, pero que tienen autonomía propia para atacar. Dados los riesgos de los aviones autónomos (por ejemplo, posibles ataques a inocentes sin diferenciarlos de culpables) se trabaja en su prohibición, pero ahora mismo los diálogos están atascados.

Igualmente, ¿qué pasaría si una IA está entrenada para vigilar constantemente toda cámara de seguridad y avisar en cuanto vea algo sospechoso? ¿O si un gobierno utilizara estas herramientas para ejercer un control total sobre la población? ¿Es lícito este uso de los programas? ¿Y es culpa de la IA, o de aquellos que la usan?

En resumen, tenemos dos puntos bien diferenciados:

- Las inteligencias artificiales son programas, que por sí mismos son completamente inofensivos. ¿Debería preocuparnos el desarrollo de la IA? No, debería preocuparnos el uso que se le dé a estos programas, que por supuesto, pueden suponer a la larga un control masivo y un ataque a derechos fundamentales de la población… como muchas otras cosas.

- ¿Nos debe preocupar el desarrollo de una singularidad? Al menos, de momento no. No entendemos la consciencia, y la investigación en IA no está orientada a la creación de máquinas conscientes, sino a la creación de software útil. No estamos ni por asomo cerca de construir una máquina así… y si deberíamos construirla o no, es un debate totalmente diferente.

La IA y los medios

Por último, un comentario al tratamiento que se le da al tema de la inteligencia artificial en los medios. En mi opinión, esta peca a menudo de alarmista, y trata de encajar a todas las inteligencias artificiales dentro del caso 2 que acabo de explicar: es decir, como si cualquier avance en inteligencia artificial fuera un paso más hacia una singularidad, lo cual, repito, no es así: ni son programas que quieran avanzar hacia allí, ni suponen un avance directo hacia ese punto. Por otro lado, las noticias que aparecen tienen siempre un cariz negativo: no hay rastro de los avances, especialmente en el campo de análisis de imagen y datos para medicina, que serán de gran utilidad en un futuro relativamente próximo.

Por otro lado, pecan de omisión: por ejemplo, creo que no se ha dado apenas protagonismo al hecho de que hay países interesados en desarrollar armas autónomas, con capacidad de matar personas sin responsabilidad humana.

Permítanme acabar con el caso de la inteligencia artificial cerrada por Facebook que inventó su propio lenguaje. Los investigadores estaban desarrollando una interfaz para mejorar las negociaciones. Al programa se le daban unos cuantos objetos, por ejemplos, dos manzanas, tres plátanos y un libro, y dos negociadores con intereses opuestos tenían que repartirse los objetos. La idea era conseguir una ayuda para negociar de forma satisfactoria y llegar a un acuerdo.

Cuando las IAs de Facebook conversaban con humanos, no había ningún problema. Al igual que Watson, estaban bien entrenadas. Son educadas, correctas y casi indistinguibles de otra persona, haciendo la negociación agradable. Sin embargo, cuando los robots hablaron entre ellos, empezaron a desviarse del lenguaje comprensible. ¿Por qué?

Después de todo lo que hemos explicado en este artículo, no debe ser difícil de entender. El objetivo de esta IA es el intercambio. A la hora de entrenar a la IA, se hacen copias de la red neuronal y la que consiga los intercambios más satisfactorios es la seleccionada. Esto se hace continuamente. Cuando se prueba la IA con humanos, un robot que hable un inglés correcto y comprensible por el otro negociador es indispensable. Sin embargo, cuando se enfrentan dos ordenadores entre ellos, no hace falta ser tan estricto con el idioma. De todas las copias que se hicieron con pequeños cambios aleatorios, algunos hablaban peor el inglés. Con las personas, estos eran descartados, pero ahora, por alguna razón, resultaron beneficiosos. Esto siguió avanzando hasta que el idioma fue irreconocible: sin embargo, resultaba más provechoso para los intercambios.

Facebook no cerró la IA por miedo, porque el programa estuviera fuera de control, o por cualquier otro extraño motivo. Cerró la IA porque los programadores tuvieron un fallo: no fijaron que el idioma que se hablara debía ser inmutable. Sin esta condición, los programas han hecho exactamente aquello para lo que estaban programados: cambiar su red neuronal para conseguir mejores intercambios. Y si eso fastidia el inglés, no nos importa.

Con lo cual, las reflexiones:

- Sabiendo que una IA conversacional solo da preguntas y respuestas, y que aprende imitando su entorno, ¿por qué cuando coge la información de todos los trolls de Internet y se vuelve “malvada” es noticia? Está claro que a una IA que interaccione libremente con usuarios le va a pasar eso, y no deja de marcar titulares cada vez que pasa.

- Cuando una IA hace algo curioso por el error o el descuido de un programador, como el caso de Facebook, ¿de verdad es tan interesante como para ocupar cientos de artículos en Internet? Fue solamente un olvido, que nos deja una historia curiosa, pero no supone ni un avance para la IA, ni tampoco un riesgo de ninguna clase.

- Realmente, sobre la IA que desarrollaba Facebook, de verdad, ¿no os preocupa más que los intercambios comerciales estén llevados a cabo por inteligencias artificiales de forma exclusiva, sin contar con el consentimiento de una persona? ¿Eso no tiene consecuencias éticas de alto interés en temas como la redistribución de la riqueza o la sociedad? Porque no he visto ningún comentario al respecto, y en mi opinión es un debate mucho más interesante y necesario que los titulares que se le han dedicado a esa noticia.

- ¿Por qué cualquier noticia de IA está orientada a un acercamiento a la singularidad, cuando la mayor parte de los programas desarrollados actualmente no están orientados a este objetivo?

- ¿Por qué buena parte de las noticias de IA tienen cariz negativo, olvidando todas las ventajas que ya proporciona esta tecnología, por no hablar de las que están por venir? Y también, ¿por qué no se denuncian en la prensa los malos usos deliberados de esta tecnología, que son mucho más perjudiciales que todas las noticias alarmistas que aparecen habitualmente en los medios?

Espero que el artículo en general, y mis reflexiones personales, en particular, sean de utilidad tanto a los que escriben las noticias sobre inteligencia artificial, como para los que las leen: porque el león no es tan fiero como lo pintan. Skynet está aún fuera de nuestro alcance, y, sin embargo, tenemos a nuestro lado una tecnología que puede revolucionar muchas cosas en el mundo, para bien, así que, ¿por qué no usarla de forma responsable?

Para leer más:

- Francisco Villatoro sobre AlphaGo: http://francis.naukas.com/tag/alphago/

- Algunas aplicaciones de la IA en nuestras vidas (que usamos casi a diario): http://techcetera.co/10-ejemplos-usamos-inteligencia-artificial-diario/

- Sobre el debate y las negociaciones de las armas autónomas: http://www.lamarea.com/tags/robots-asesinos/

- Entrevista a Stuart Russel, sobre inteligencia artificial (inglés): http://www.businessinsider.com/artificial-intelligence-machine-consciousness-expert-stuart-russell-future-ai-2015-7

- Un artículo de Gizmodo que aclara el caso de la IA de Facebook (inglés): https://gizmodo.com/no-facebook-did-not-panic-and-shut-down-an-ai-program-1797414922

- Página oficial del grupo Google DeepMind, creadores de AlphaGo (inglés): https://deepmind.com/

- (Técnico) Informe sobre la fiabilidad actual del reconocimiento automático de electrocardiogramas: http://www.nejm.org/doi/full/10.1056/NEJM199112193252503

- (Técnico) Artículo que explica en detalle el diseño, implementación, y entrenamiento de AlphaGo: http://www.nature.com/nature/journal/v529/n7587/full/nature16961.html?foxtrotcallback=true